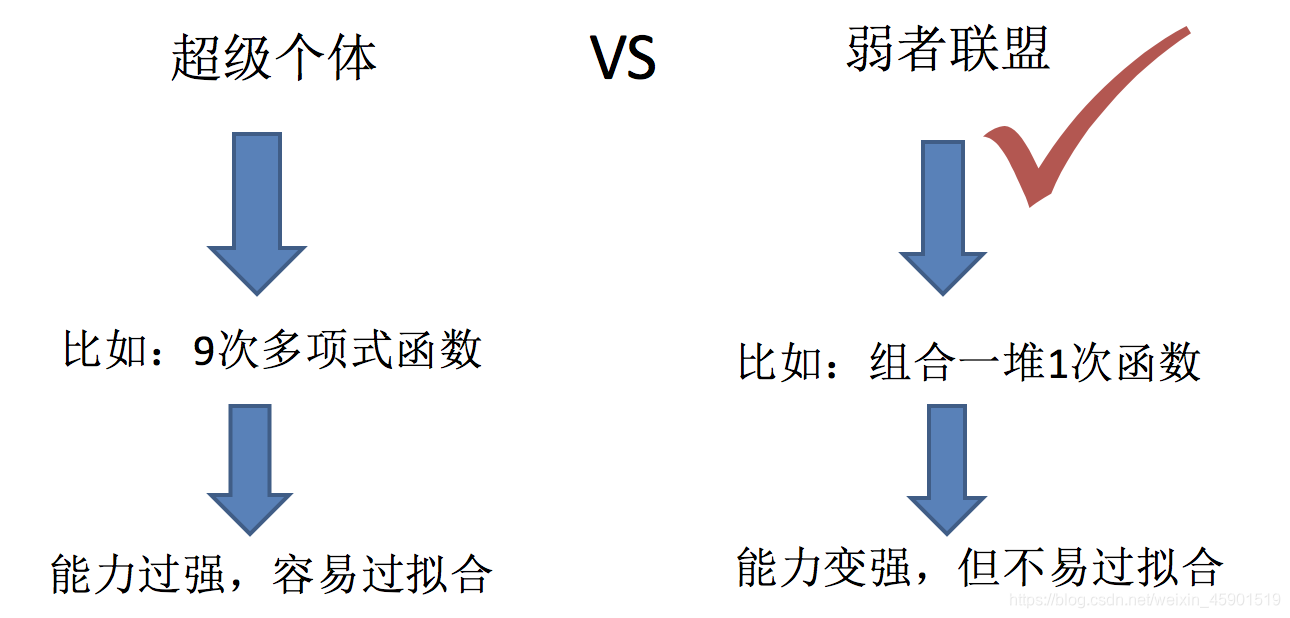

集成学习之Boosting 1.boosting集成原理 1.1 什么是boosting 随着学习的积累从弱到强 简而言之:每新加入一个弱学习器,整体能力就会得到提升 代表算法:Adaboost,GBDT,XGBoost 1.2 实现过程: 1.训练第...

”boosting 集成学习“ 的搜索结果

机器学习_集成学习之Boosting(提升较弱的模型,以降低弱模型的偏差)

代表:Adaboost(Adaptive boosting)公式推导可见《机器学习》P174优点:泛化错误率低,易编码,可以应用在大部分分类器上,无参数调整缺点

boosting算法是一类将弱学习器提升为强学习器的集成学习算法,它通过改变训练样本的权值,学习多个分类器,并将这些分类器进行线性组合,提高泛化性能。

集成学习-boosting

标签: 机器学习

Boosting是一族将弱学习器提升为强学习器的算法,适用于个体学习器间存在强依赖关系、必须串行生成序列化方法。最著名的代表是AdaBoost。 Boosting的工作机制:从初始的训练集中训练出一个基学习器,再根据基学习器...

集成学习概览_Bagging与Boosting1

Boosting就是集成多个弱学习器,每个弱学习器都是针对训练数据的不同子集训练得到的,而每个弱学习器都会根据前一个弱学习器的表现进行加权,从而使得模型更加关注之前被错误分类的样本,进而提高模型的预测准确率和...

GBDT是一个基于迭代累加的决策树算法,它通过构造一组弱的学习器(树),并把多颗...GBDT也是集成学习Boosting家族的成员,但是却和传统的Adaboost有很大的不同。回顾下Adaboost,我们是利用前一轮迭代弱学习器的...

Boosting集成学习和非集成学习的主要区别在于数据集的处理方式和模型训练的策略。在非集成学习中,我们通常使用单个模型来训练数据集,并对其进行优化,以获得最佳的预测结果。而在Boosting集成学习中,我们会使用多...

之前的博文中我们提到过Boosting集成学习方法是个体学习器串行的序列化方法,这种方式中个体学习器存在强依赖的关系。 该方法的工作机制:我们先从初始的训练集中训练出一个基学习器,然后根据基学习器的表现对训练...

Boosting集成学习总结

Boosting集成学习算法简介 ## 1.1 Boosting算法概述 Boosting算法是一种集成学习方法,通过结合多个弱分类器来构建一个强分类器的技术。其核心思想是通过迭代,每一次迭代都关注于之前分类器分类错误的样本,逐步...

## 1.1 介绍Boosting集成学习算法在图像识别中的重要性 在图像识别领域,Boosting集成学习算法作为一种重要的机器学习方法,在提高图像识别准确性和鲁棒性方面发挥着重要作用。通过结合多个弱分类器来构建强分类器...

一、什么是集成学习: 1、集成学习的含义 集成学习:指构建多个分类器(弱...集成学习根据各个弱分类器之间有无依赖关系,分为Boosting和Bagging两大流派: (1)Boosting流派,各分类器之间有依赖关系,必须串行...

XGBoost全名叫(eXtreme Gradient Boosting)极端梯度提升,经常被用在一些项目中,其效果显著。它是大规模并行boosted tree的工具,它是目前最快最好的开源boosted tree工具包。XGBoost 所应用的算法就是GBDT...

Boosting集成学习算法概述 ## 1.1 集成学习算法简介 集成学习(Ensemble Learning)是通过构建并结合多个学习器来完成学习任务的一种机器学习方法。它的核心思想是“三个臭皮匠,顶个诸葛亮”,通过集成多个模型的...

Boosting集成学习算法概述 Boosting集成学习算法是一种通过顺序训练多个弱分类器,并将它们组合成一个强分类器的集成方法。本章将介绍Boosting算法的基本原理、在机器学习中的应用概述,以及在自然语言处理中的...

其中,Boosting集成学习算法作为一种强大的机器学习算法,在医疗诊断中展现出了巨大的潜力和优势。 ## 1.2 目前医疗诊断中存在的挑战 在传统的医疗诊断中,医生往往依靠临床经验和个人知识进行诊断,这种方法存在...

在前一篇文章中我们介绍了集成学习算法中的Bagging模型,本篇文章将继续介绍集成学习算法中的另一个代表性算法Boosting模型。Boosting是一种可将弱学习器提升为强学习器的算法。其工作机制为:先从初始训练集训练出...

浅浅介绍了boost, bagging, stacking 的一些基本原理。内含NLP特征工程分类任务(小说新闻分类),2023美赛春季赛Y题二手帆船价格预测回归任务。

# 1. 引言 ## 1.1 研究背景与意义 在当今信息化社会,各种企业和组织面临着越来越复杂和隐蔽的安全威胁,如数据泄露、网络攻击等。因此,异常检测作为保障信息系统安全的重要手段受到了广泛关注。...

一.bagging、boosting集成学习 二.随机森林 一.bagging、boosting集成学习 1.bagging: 从原始样本集中独立地进行k轮抽取,生成训练集。每轮从原始样本集中使用Bootstraping方法抽取(即又放回地抽取)n个样本...

1,Bagging Bagging即套袋法,其算法过程如下: 1,从原始样本集中抽取训练集。每轮从原始样本集中使用Bootstraping的方法(有放回)抽取n个训练样本(在训练集中,有些样本可能被多次抽取到,而有些样本可能一次都...

集成学习(Ensemblelearning)通过组合几种模型来提高机器学习的效果。与单一模型相比,该方法可以提供更好的预测结果。正因为如此,集成方法在许多著名的机器学习比赛(如 Netflix、KDD2009和Kaggle比赛)中能够...

推荐文章

- Java---简单易懂的KNN算法_jf.knn-%; 9 &-程序员宅基地

- 最新版ffmpeg 提取视频关键帧_从视频中获取flag-程序员宅基地

- 【ARM Cache 系列文章 11 -- ARM Cache 直接映射 详细介绍】

- Objective-C学习计划

- 【数据结构】最小生成树(Prim算法、Kruskal算法)解析+完整代码

- python访问组策略_python 模块 wmi 远程连接 windows 获取配置信息-程序员宅基地

- html把div做成透明背景,DIV半透明层 CSS来实现网页背景半透明-程序员宅基地

- 关机恶搞小程序

- mnist手写数字分类的python实现_TensorFlow的MNIST手写数字分类问题 基础篇-程序员宅基地

- wxpython窗口跳转_WxPython-用按钮打开一个新窗口-程序员宅基地